Basierend auf echten Benchmark-Daten aus unseren eigenen Softwareprodukten haben wir die Leistungsfähigkeit verschiedener LLM-Modelle bei der Bewältigung spezifischer Herausforderungen bewertet. Dabei wurden spezifische Kategorien wie Dokumentenverarbeitung, CRM-Integration, externe Integration, Marketingunterstützung und Codegenerierung untersucht.

Juli 2024 war ein sehr spannender Monat in der Welt der generativen KI. Es wurden sogar ein paar Grenzen verschoben.

Die Highlights des Monats:

- Codestral-Mamba 7B - neue effiziente LLM-Architektur, die erstaunlich gute Ergebnisse erzielt

GPT-4o Mini - günstiges, leichtes Modell. Das beste in seiner Klasse!

Mistral Nemo 12B - anständiges downloadbares Modell in seiner Klasse, entwickelt für Quantisierung (Kompression)

Mistral Large 123B v2 - lokales Modell, das das Niveau von GPT-4 Turbo v3 und Gemini Pro 1.5 erreicht. Es wäre das beste lokale Modell, wäre da nicht Meta Llama 3.1:

Meta Llama 3.1 - eine Reihe von Modellen mit freizügiger Lizenz, die in unserem Benchmark neue Rekorde aufgestellt haben.

+++ Update +++

Gemini Pro 1.5 v0801 - Google schafft es plötzlich mit OpenAI gleichzuziehen und schafft es in die Top 3!

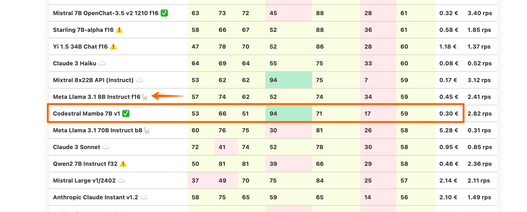

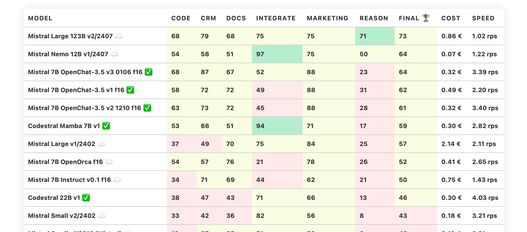

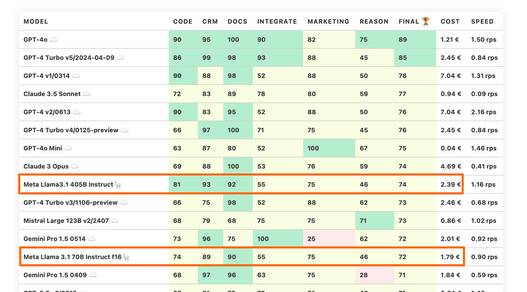

LLM Benchmarks | Juli 2024

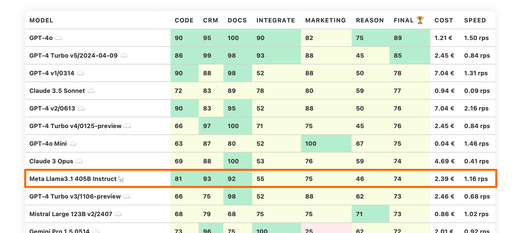

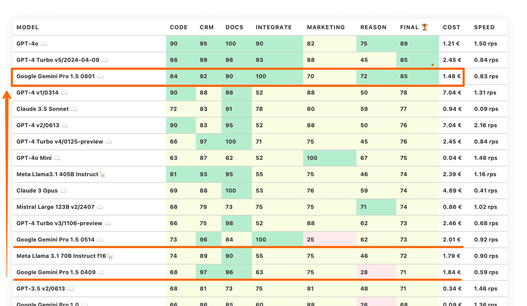

Unsere Benchmarks bewerten die Modelle in Bezug auf ihre Eignung für die digitale Produktentwicklung. Je höher die Punktezahl, desto besser.

☁️ - Cloud-Modelle mit proprietärer Lizenz

✅ - Open-Source-Modelle, die lokal ohne Einschränkungen ausgeführt werden können

🦙 - Lokale Modelle mit Llama2-Lizenz

Eine genauere Erläuterung zu den jeweiligen Kategorien finden Sie unter der Tabelle.

| Modell | Code | Crm | Docs | Integrate | Marketing | Reason | Ergebnis | Kosten | Speed |

|---|---|---|---|---|---|---|---|---|---|

| GPT-4o ☁️ | 90 | 95 | 100 | 90 | 82 | 75 | 89 | 1.21 € | 1.50 rps |

| GPT-4 Turbo v5/2024-04-09 ☁️ | 86 | 99 | 98 | 93 | 88 | 45 | 85 | 2.45 € | 0.84 rps |

| Google Gemini Pro 1.5 0801 ☁️ | 84 | 92 | 90 | 100 | 70 | 72 | 85 | 1.48 € | 0.83 rps |

| GPT-4 v1/0314 ☁️ | 90 | 88 | 98 | 52 | 88 | 50 | 78 | 7.04 € | 1.31 rps |

| Claude 3.5 Sonnet ☁️ | 72 | 83 | 89 | 78 | 80 | 59 | 77 | 0.94 € | 0.09 rps |

| GPT-4 v2/0613 ☁️ | 90 | 83 | 95 | 52 | 88 | 50 | 76 | 7.04 € | 2.16 rps |

| GPT-4 Turbo v4/0125-preview ☁️ | 66 | 97 | 100 | 71 | 75 | 45 | 76 | 2.45 € | 0.84 rps |

| GPT-4o Mini ☁️ | 63 | 87 | 80 | 52 | 100 | 67 | 75 | 0.04 € | 1.46 rps |

| Claude 3 Opus ☁️ | 69 | 88 | 100 | 53 | 76 | 59 | 74 | 4.69 € | 0.41 rps |

| Meta Llama3.1 405B Instruct🦙 | 81 | 93 | 92 | 55 | 75 | 46 | 74 | 2.39 € | 1.16 rps |

| GPT-4 Turbo v3/1106-preview ☁️ | 66 | 75 | 98 | 52 | 88 | 62 | 73 | 2.46 € | 0.68 rps |

| Mistral Large 123B v2/2407 ☁️ | 68 | 79 | 68 | 75 | 75 | 71 | 73 | 0.86 € | 1.02 rps |

| Gemini Pro 1.5 0514 ☁️ | 73 | 96 | 75 | 100 | 25 | 62 | 72 | 2.01 € | 0.92 rps |

| Meta Llama 3.1 70B Instruct f16🦙 | 74 | 89 | 90 | 55 | 75 | 46 | 72 | 1.79 € | 0.90 rps |

| Gemini Pro 1.5 0409 ☁️ | 68 | 97 | 96 | 63 | 75 | 28 | 71 | 1.84 € | 0.59 rps |

| GPT-3.5 v2/0613 ☁️ | 68 | 81 | 73 | 75 | 81 | 48 | 71 | 0.34 € | 1.46 rps |

| GPT-3.5 v3/1106 ☁️ | 68 | 70 | 71 | 63 | 78 | 59 | 68 | 0.24 € | 2.33 rps |

| Gemini Pro 1.0 ☁️ | 66 | 86 | 83 | 60 | 88 | 26 | 68 | 0.09 € | 1.36 rps |

| GPT-3.5 v4/0125 ☁️ | 63 | 87 | 71 | 60 | 78 | 47 | 68 | 0.12 € | 1.43 rps |

| Gemini 1.5 Flash 0514 ☁️ | 32 | 97 | 100 | 56 | 72 | 41 | 66 | 0.09 € | 1.77 rps |

| Cohere Command R+ ☁️ | 63 | 80 | 76 | 49 | 70 | 59 | 66 | 0.83 € | 1.90 rps |

| Qwen1.5 32B Chat f16 ⚠️ | 70 | 90 | 82 | 56 | 78 | 15 | 65 | 0.97 € | 1.66 rps |

| GPT-3.5-instruct 0914 ☁️ | 47 | 92 | 69 | 60 | 88 | 32 | 65 | 0.35 € | 2.15 rps |

| Mistral Nemo 12B v1/2407 ☁️ | 54 | 58 | 51 | 97 | 75 | 50 | 64 | 0.07 € | 1.22 rps |

| Mistral 7B OpenChat-3.5 v3 0106 f16 ✅ | 68 | 87 | 67 | 52 | 88 | 23 | 64 | 0.32 € | 3.39 rps |

| Meta Llama 3 8B Instruct f16🦙 | 79 | 62 | 68 | 49 | 80 | 42 | 64 | 0.32 € | 3.33 rps |

| GPT-3.5 v1/0301 ☁️ | 55 | 82 | 69 | 67 | 82 | 24 | 63 | 0.35 € | 4.12 rps |

| Gemma 7B OpenChat-3.5 v3 0106 f16 ✅ | 63 | 67 | 84 | 33 | 81 | 48 | 63 | 0.21 € | 5.09 rps |

| Llama 3 8B OpenChat-3.6 20240522 f16 ✅ | 76 | 51 | 76 | 45 | 88 | 39 | 62 | 0.28 € | 3.79 rps |

| Mistral 7B OpenChat-3.5 v1 f16 ✅ | 58 | 72 | 72 | 49 | 88 | 31 | 62 | 0.49 € | 2.20 rps |

| Mistral 7B OpenChat-3.5 v2 1210 f16 ✅ | 63 | 73 | 72 | 45 | 88 | 28 | 61 | 0.32 € | 3.40 rps |

| Starling 7B-alpha f16 ⚠️ | 58 | 66 | 67 | 52 | 88 | 36 | 61 | 0.58 € | 1.85 rps |

| Yi 1.5 34B Chat f16 ⚠️ | 47 | 78 | 70 | 52 | 86 | 28 | 60 | 1.18 € | 1.37 rps |

| Claude 3 Haiku ☁️ | 64 | 69 | 64 | 55 | 75 | 33 | 60 | 0.08 € | 0.52 rps |

| Mixtral 8x22B API (Instruct) ☁️ | 53 | 62 | 62 | 94 | 75 | 7 | 59 | 0.17 € | 3.12 rps |

| Meta Llama 3.1 8B Instruct f16🦙 | 57 | 74 | 62 | 52 | 74 | 34 | 59 | 0.45 € | 2.41 rps |

| Codestral Mamba 7B v1 ✅ | 53 | 66 | 51 | 94 | 71 | 17 | 59 | 0.30 € | 2.82 rps |

| Meta Llama 3.1 70B Instruct b8🦙 | 60 | 76 | 75 | 30 | 81 | 26 | 58 | 5.28 € | 0.31 rps |

| Claude 3 Sonnet ☁️ | 72 | 41 | 74 | 52 | 78 | 30 | 58 | 0.95 € | 0.85 rps |

| Qwen2 7B Instruct f32 ⚠️ | 50 | 81 | 81 | 39 | 66 | 29 | 58 | 0.46 € | 2.36 rps |

| Mistral Large v1/2402 ☁️ | 37 | 49 | 70 | 75 | 84 | 25 | 57 | 2.14 € | 2.11 rps |

| Anthropic Claude Instant v1.2 ☁️ | 58 | 75 | 65 | 59 | 65 | 14 | 56 | 2.10 € | 1.49 rps |

| Anthropic Claude v2.0 ☁️ | 63 | 52 | 55 | 45 | 84 | 35 | 55 | 2.19 € | 0.40 rps |

| Cohere Command R ☁️ | 45 | 66 | 57 | 55 | 84 | 26 | 55 | 0.13 € | 2.50 rps |

| Qwen1.5 7B Chat f16 ⚠️ | 56 | 81 | 60 | 34 | 60 | 36 | 55 | 0.29 € | 3.76 rps |

| Anthropic Claude v2.1 ☁️ | 29 | 58 | 59 | 60 | 75 | 33 | 52 | 2.25 € | 0.35 rps |

| Mistral 7B OpenOrca f16 ☁️ | 54 | 57 | 76 | 21 | 78 | 26 | 52 | 0.41 € | 2.65 rps |

| Qwen1.5 14B Chat f16 ⚠️ | 50 | 58 | 51 | 49 | 84 | 17 | 51 | 0.36 € | 3.03 rps |

| Meta Llama 3 70B Instruct b8🦙 | 51 | 72 | 53 | 29 | 82 | 18 | 51 | 6.97 € | 0.23 rps |

| Mistral 7B Instruct v0.1 f16 ☁️ | 34 | 71 | 69 | 44 | 62 | 21 | 50 | 0.75 € | 1.43 rps |

| Llama2 13B Vicuna-1.5 f16🦙 | 50 | 37 | 53 | 39 | 82 | 38 | 50 | 0.99 € | 1.09 rps |

| Google Recurrent Gemma 9B IT f16 ⚠️ | 58 | 27 | 71 | 45 | 56 | 25 | 47 | 0.89 € | 1.21 rps |

| Codestral 22B v1 ✅ | 38 | 47 | 43 | 71 | 66 | 13 | 46 | 0.30 € | 4.03 rps |

| Llama2 13B Hermes f16🦙 | 50 | 24 | 30 | 61 | 60 | 43 | 45 | 1.00 € | 1.07 rps |

| Llama2 13B Hermes b8🦙 | 41 | 25 | 29 | 61 | 60 | 43 | 43 | 4.79 € | 0.22 rps |

| Mistral Small v2/2402 ☁️ | 33 | 42 | 36 | 82 | 56 | 8 | 43 | 0.18 € | 3.21 rps |

| Mistral Small v1/2312 (Mixtral) ☁️ | 10 | 67 | 65 | 51 | 56 | 8 | 43 | 0.19 € | 2.21 rps |

| IBM Granite 34B Code Instruct f16 ☁️ | 63 | 49 | 30 | 44 | 57 | 5 | 41 | 1.07 € | 1.51 rps |

| Mistral Medium v1/2312 ☁️ | 41 | 43 | 27 | 59 | 62 | 12 | 41 | 0.81 € | 0.35 rps |

| Llama2 13B Puffin f16🦙 | 37 | 15 | 38 | 48 | 56 | 41 | 39 | 4.70 € | 0.23 rps |

| Mistral Tiny v1/2312 (7B Instruct v0.2) ☁️ | 22 | 47 | 57 | 40 | 59 | 8 | 39 | 0.05 € | 2.39 rps |

| Llama2 13B Puffin b8🦙 | 37 | 14 | 37 | 46 | 56 | 39 | 38 | 8.34 € | 0.13 rps |

| Meta Llama2 13B chat f16🦙 | 22 | 38 | 17 | 45 | 75 | 8 | 34 | 0.75 € | 1.44 rps |

| Meta Llama2 13B chat b8🦙 | 22 | 38 | 15 | 45 | 75 | 6 | 33 | 3.27 € | 0.33 rps |

| Mistral 7B Zephyr-β f16 ✅ | 37 | 34 | 46 | 44 | 29 | 4 | 32 | 0.46 € | 2.34 rps |

| Meta Llama2 7B chat f16🦙 | 22 | 33 | 20 | 42 | 50 | 20 | 31 | 0.56 € | 1.93 rps |

| Mistral 7B Notus-v1 f16 ⚠️ | 10 | 54 | 25 | 41 | 48 | 4 | 30 | 0.75 € | 1.43 rps |

| Orca 2 13B f16 ⚠️ | 18 | 22 | 32 | 22 | 67 | 19 | 30 | 0.95 € | 1.14 rps |

| Mistral 7B Instruct v0.2 f16 ☁️ | 11 | 30 | 50 | 13 | 58 | 8 | 29 | 0.96 € | 1.12 rps |

| Mistral 7B v0.1 f16 ☁️ | 0 | 9 | 42 | 42 | 52 | 12 | 26 | 0.87 € | 1.23 rps |

| Google Gemma 2B IT f16 ⚠️ | 33 | 28 | 14 | 39 | 15 | 20 | 25 | 0.30 € | 3.54 rps |

| Microsoft Phi 3 Medium 4K Instruct f16 ⚠️ | 5 | 34 | 30 | 13 | 47 | 8 | 23 | 0.82 € | 1.32 rps |

| Orca 2 7B f16 ⚠️ | 22 | 0 | 24 | 18 | 52 | 4 | 20 | 0.78 € | 1.38 rps |

| Google Gemma 7B IT f16 ⚠️ | 0 | 0 | 0 | 9 | 62 | 0 | 12 | 0.99 € | 1.08 rps |

| Meta Llama2 7B f16🦙 | 0 | 5 | 18 | 3 | 28 | 2 | 9 | 0.95 € | 1.13 rps |

| Yi 1.5 9B Chat f16 ⚠️ | 0 | 4 | 29 | 8 | 0 | 8 | 8 | 1.41 € | 0.76 rps |

Wie gut kann das Modell mit großen Dokumenten und Wissensdatenbanken arbeiten?

Wie gut unterstützt das Modell die Arbeit mit Produktkatalogen und Marktplätzen?

Kann das Modell problemlos mit externen APIs, Diensten und Plugins interagieren?

Wie gut kann das Modell bei Marketingaktivitäten unterstützen, z.B. beim Brainstorming, der Ideenfindung und der Textgenerierung?

Wie gut kann das Modell in einem gegebenen Kontext logisch denken und Schlussfolgerungen ziehen?

Kann das Modell Code generieren und bei der Programmierung helfen?

Die geschätzten Kosten für die Ausführung der Arbeitslast. Für cloud-basierte Modelle berechnen wir die Kosten gemäß der Preisgestaltung. Für lokale Modelle schätzen wir die Kosten auf Grundlage der GPU-Anforderungen für jedes Modell, der GPU-Mietkosten, der Modellgeschwindigkeit und des operationellen Overheads.

Die Spalte "Speed" gibt die geschätzte Geschwindigkeit des Modells in Anfragen pro Sekunde an (ohne Batching). Je höher die Geschwindigkeit, desto besser.

Tiefere Einblicke

Codestral Mamba 7B

Mistral AI hat diesen Monat eine ganze Reihe von Veröffentlichungen gemacht, aber Codestral Mamba ist unser Favorit. Es ist nicht extrem leistungsgstark, vergleichbar mit Modellen wie Llama 3.1 8B oder Claude 3 Sonnet. Aber es gibt auch ein paar Nachteile:

Dieses Modell ist nicht für Produkt- oder Businessaufgaben konzipiert, es ist ein Coding-Modell. Dennoch konkurriert es gut mit Allzweckmodellen.

Das Modell hat nicht die gut erforschte Transformer-Architektur implementiert, sondern eine Mamba (auch bekannt als Linear-Time Sequence Modeling with Selective State Spaces). Diese Architektur gilt als ressourceneffizienter und hat weniger Beschränkungen bei der Arbeit mit großen Kontexten. Es gab mehrere Versuche, ein gutes Mamba-Modell zu trainieren, aber dies ist das erste Modell, das in unserer Rangliste gute Ergebnisse erzielt.

Das neue Modell ist für den lokalen Gebrauch verfügbar, man kann es direkt von HuggingFace beziehen. Nvidia TensorRT-LLM unterstützt dieses Modell bereits.

GPT-4o Mini

GPT-4o Mini ist ein neues multimodales Modell von OpenAI. Es ähnelt in seiner Klasse den GPT-3.5-Modellen, hat aber bessere Gesamtergebnisse. Seine Grundfähigkeiten sind ziemlich groß für ein so kleines Modell. GPT-4o Mini ist auch das erste Modell, das in unserer Kategorie Marketing (Tests, die mit Sprache und Schreibstilen arbeiten) eine perfekte 100 erreicht hat.

Angesichts der extrem niedrigen Kosten und der guten Ergebnisse scheint der GPT-4o Mini perfekt für kleine, fokussierte Aufgaben wie Router und Klassifikatoren in LLM-gesteuerten Produkten geeignet zu sein. Auch Datenextraktionsaufgaben in großem Maßstab sehen gut aus.

Mistral Nemo 12B

Wie es scheint, hat Mistral AI eine Menge Anstrengungen in die Spitzenforschung und -entwicklung gesteckt. Der Mistral Nemo 12B ist ein weiteres Beispiel dafür.

Einerseits ist dieses Modell etwas größer als frühere 7B-Modelle von Mistral AI. Andererseits hat es ein paar interessante Nuancen, die das wieder wettmachen.

Erstens verfügt das Modell über einen besseren Tokeniser, was zu einer effizienteren Verwendung von Token führt (weniger Token pro Eingabe und Ausgabe erforderlich).

Zweitens wurde das Modell zusammen mit Nvidia unter Verwendung eines quantisierungssensitiven Trainings trainiert. Das bedeutet, dass das Modell von Anfang an auf einen ressourceneffizienten Betrieb ausgelegt ist. In diesem Fall ist das Modell so konzipiert, dass es im FP8-Modus gut funktioniert, was bedeutet, dass die Modellgewichte ein Viertel der üblichen Größe im Speicher einnehmen (im Vergleich zum FP32-Format). Hier ist die Ankündigung von Nvidia.

Es ist ein netter Zufall, dass NVidia-GPUs mit CUDA Compute 9.0-Generation darauf ausgelegt sind, FP8 nativ auszuführen (z. B. H100-GPUs für Rechenzentren)

Wenn Sie die neuesten GPUs haben, kann dieses Mistral Nemo Modell ein guter Ersatz für die früheren 7B Modelle von Mistral AI sein. Da das Modell auch einen hohen Reason-Wert erzielt, besteht die Chance, dass die Feinabstimmung das Modell noch höher treibt.

Sie können dieses Modell von Hugging Face herunterladen oder über die MistralAI API verwenden.

Mistral Large 123B v2

Mistral Large v2 ist derzeit das beste Modell von Mistral in unseren Benchmarks. Es steht zum Download zur Verfügung, d.h. Sie können es auf Ihren lokalen Rechnern ausführen (obwohl für die kommerzielle Nutzung eine Lizenz erforderlich ist).

Dieses Modell hat auch einen großen Kontext von 128 Token. Es behauptet, dass es mehrere Sprachen unterstützt, sowohl menschliche als auch Programmiersprachen.

In unserem Benchmark hat dieses Modell wirklich gute Ergebnisse und eine ungewöhnlich hohe Reason-Fähigkeit. Es ist vergleichbar mit GPT-4 Turbo v3, Gemini Pro 1.5 und Claude 3 Opus.

Die ungewöhnliche Größe dieses Mistral Modells könnte darauf hindeuten, dass es auch mit FP8 Awareness trainiert wurde, um die 70B Modi in ihrem Lineup zu ersetzen (12:7 ~~ 123:80). Wenn das der Fall ist, könnten wir einen allgemeinen Trend sehen, bei dem neue Modelle in diesen ungeraden Größen auftauchen werden. Sie werden allerdings nur auf den neuesten GPUs gut laufen. Dies kann die LLM-Landschaft fragmentieren und den Fortschritt verlangsamen.

Das Lineup der besten Mistral-Modelle sieht derzeit wie folgt aus:

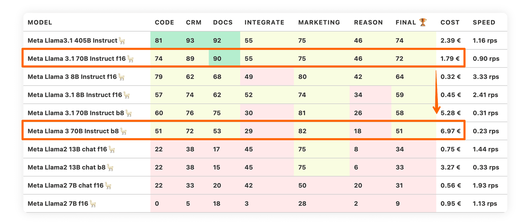

Llama 3.1 Models from Meta

Meta hat ein Update seiner Llama 3.1-Reihe veröffentlicht, das 3 Modellgrößen umfasst: 8B, 70B und 405B. Sie können alle Modelle von HuggingFace herunterladen und lokal verwenden. Die meisten KI-Anbieter bieten auch Unterstützung über API an.

Wir haben kleinere Modelle lokal getestet und Google Vertex AI für 405B verwendet. Google hat die Integration so gut wie nicht vermasselt (Sie müssen eventuell die Zeilenumbrüche korrigieren und zusätzliche Token am Anfang der Eingabeaufforderung abschneiden).

Das Modell 8B ist nicht so interessant - es schneidet schlechter ab als die vorherige Version 3.0, also lassen wir es weg. Die beiden anderen Modelle sind viel interessanter.

Meta Llama 3.1 70B hat einen massiven Qualitätssprung gemacht, wenn man es mit der vorherigen Version vergleicht. Es hat Gemini Pro 1.5 erreicht, GPT-3.5 übertroffen und Mistral Large 123B v2 erreicht. Das sind großartige Neuigkeiten, denn wir können die Qualität des 123B-Modells mit einem kleineren Modell erreichen.

Beachten Sie übrigens, dass Llama 3.1-Modelle ziemlich empfindlich auf Quantisierung (Komprimierung) reagieren können. Wenn wir z.B. ein 70B-Modell mit einer 8bit-Quantisierung (über bitsandbytes) laufen lassen, wird die Leistung und Qualität drastisch sinken:

Das bedeutet nicht, dass alle Quantisierungsstrategien gleich schlecht sind (hier finden Sie einen guten Artikel zu diesem Thema). Stellen Sie nur sicher, dass Sie Ihr Modell auf Ihrer Hardware mit Ihren spezifischen Daten vergleichen.

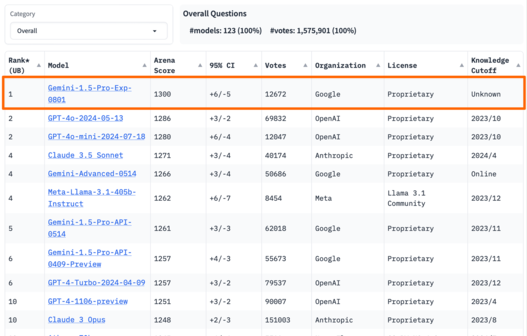

Meta Llama 3.1 405B Instruct

Meta Llama 3.1 405B Instruct ist der letzte Held des Monats. Dies ist das erste Modell, das es geschafft hat, den GPT-4 Turbo (seine schwächste Version Turbo v3/1106) zu schlagen. Sie können es in den TOP 10 unseres Benchmarks finden:

Es ist ein großes Modell. Sie benötigen 640 GB VRAM (8xH100/A100), nur um es im FP8 mit einem kleinen Batch- und Kontextfenster zu betreiben. Allein die Ressourcenanforderungen bedeuten, dass nur sehr wenige dieses Modell verwenden werden, wenn man es mit 70B/8B-Varianten vergleicht. Es wird weniger interessante Feinabstimmungen und Lösungen geben.

Aber das ist alles nicht so wichtig. Die wichtigen Punkte sind:

Dies ist ein Modell, das Sie herunterladen und lokal verwenden können.

Es übertrifft eines der GPT-4-Modelle

Es übertrifft Mistral Large 2 in der Qualität, während es eine freizügigere Lizenz hat

Es erreicht die Qualität von Claude 3 Opus.

Dies ist ein kleiner Durchbruch. Wir sind sicher, dass irgendwann auch kleinere Modelle dieses Niveau erreichen werden.

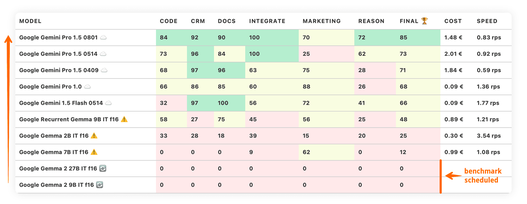

Update: Google Gemini 1.5 Pro Experimental v0801

Normalerweise führen wir keine Benchmark-Updates nach der Veröffentlichung durch, aber diese Nachricht hat es verdient. Einen Monat zu warten, um über das neue Google Gemini-Modell zu berichten, wäre eine Verschwendung.

Dieses Modell wurde am ersten August als öffentliches Experiment veröffentlicht (Sie können es im Google AI Studio finden). Zu diesem Zeitpunkt wurde auch bekannt, dass das Modell seit einiger Zeit in der LMSYS Chatbot Arena läuft und mit mehr als 12.000 Stimmen an der Spitze steht.

Wir haben unseren eigenen Benchmark über die Google AI Studio API durchgeführt (das Modell ist noch nicht auf Vertex AI verfügbar). Die Ergebnisse sind wirklich beeindruckend. Wir sprechen hier von einem erheblichen Sprung in den Modellfähigkeiten gegenüber der ersten Version von Gemini Pro 1.5 im April.

Dieses Google-Modell schaffte es plötzlich, fast alle GPT-4-Modelle zu überholen und zur Spitze aufzuschließen und den dritten Platz zu belegen. Die Ergebnisse sind solide.

Die Ergebnisse hätten sogar noch besser ausfallen können, wenn Gemini Pro 1.5 mehr darauf geachtet hätte, die Anweisungen genau zu befolgen. Während extreme Detailgenauigkeit bei menschlichen Interaktionen nicht immer erforderlich ist, ist sie bei Produkten und LLM-Pipelines, die bei unseren Kunden eingesetzt werden, unerlässlich. Die beiden besten Modelle von OpenAI übertreffen diese Fähigkeit noch.

Dennoch gibt es hervorragende Neuigkeiten: Erstens haben wir eine neue Innovationsquelle, die es geschafft hat, mit OpenAI gleichzuziehen (und wir dachten, dass Google aus dem Rennen ist). Zweitens werden Unternehmen, die sich stark in der Google Cloud engagieren, endlich Zugang zu einem hochwertigen großen Sprachmodell innerhalb des Ökosystems erhalten.

Und wer weiß, ob es Google Gemini 2.0 gelingt, die Modellfähigkeiten noch weiter zu steigern. Das Tempo des Fortschritts war bisher recht beeindruckend. Überzeugen Sie sich einfach selbst:

Local AI and Compliance

Wir beobachten diesen Trend schon seit geraumer Zeit. Lokale Modelle werden mit der Zeit immer leistungsfähiger und übertreffen komplexere Closed-Source-Modelle.

Lokale Modelle sind für viele Kunden recht interessant, da sie viele Probleme in Bezug auf Datenschutz, Vertraulichkeit und Compliance zu lösen scheinen. Die Wahrscheinlichkeit, dass private Daten nach außen dringen, ist geringer, wenn Ihre LLMs vollständig in Ihren Räumlichkeiten innerhalb des Sicherheitsbereichs laufen, oder?

Nuancen und neue Regulierungen: Das EU-KI-Gesetz

Es gibt jedoch noch einige Nuancen. Ab dem 01. August 2024 tritt in der EU das Gesetz über künstliche Intelligenz in Kraft. Es schafft einen gemeinsamen regulatorischen und rechtlichen Rahmen für KI in der EU, wobei verschiedene Bestimmungen innerhalb der nächsten 3 Jahre langsam in Kraft treten werden.

Das EU-KI-Gesetz regelt nicht nur KI-Anbieter (wie OpenAI oder MistralAI), sondern auch Unternehmen, die KI in einem professionellen Kontext nutzen.

Risikobasierte Regulierung: Was bedeutet das für Ihr Unternehmen?

Natürlich wird nicht jeder auf die gleiche Weise reguliert werden. Die Regulierung basiert auf den Risikostufen, und die meisten KI-Anwendungen dürften in die Kategorie "minimales Risiko" fallen. Es ist jedoch recht einfach, in die höhere Risikokategorie einzusteigen (z. B. wenn KI Bildmanipulationen ermöglicht, im Bildungswesen oder bei der Personalbeschaffung eingesetzt wird).

Sorgfaltspflicht: Mehr als nur lokale Modelle

Mit anderen Worten: Eine gewisse Sorgfaltspflicht wird für alle großen Unternehmen erforderlich sein. Die Aussage "Wir verwenden nur lokale Modelle" ist möglicherweise nicht ausreichend.

Checkliste zur Einhaltung der KI-Vorschriften

Hier ist ein kurzer Check, um zu sehen, ob Sie auf dem richtigen Weg sind, um die Einhaltung der Vorschriften für Ihr KI-System zu gewährleisten. Haben Sie die Antworten auf diese Fragen dokumentiert und in Ihrem Unternehmen klar kommuniziert?

Wer sind die Hauptnutzer Ihres Systems? Welches sind die Branchen und spezifischen Anwendungen Ihres Systems? Wie ist hier die Risikoklassifizierung?

Wie lauten der genaue Name, die Version, der Anbieter und die Plattform/Umgebung Ihrer KI-Komponenten?

Wie lauten die Zugehörigkeiten und Partnerschaften Ihrer KI-Anbieter? Wie lauten die Lizenzierungsbedingungen?

Wo werden Ihre Systeme geografisch eingesetzt? Unter welcher Rechtsprechung laufen Ihre KI-Systeme?

Wer ist für das System und die Prozesse zum Management von KI-Risiken in Ihrem Unternehmen verantwortlich?

Wer ist für die Dokumentation und die Kommunikation Ihres KI-Systems verantwortlich (einschließlich Dingen wie Architektur, Komponenten, Abhängigkeiten, funktionale Anforderungen und Leistungsstandards)?

Ihr Weg zur KI-Compliance

Wenn Sie konkrete Antworten auf diese Fragen haben, stehen die Chancen gut, dass Sie mit der KI-Compliance bereits auf einem guten Weg sind. Das bedeutet auch, dass Ihr Unternehmen bei der Evaluierung von LLM-gesteuerten Lösungen den Compliance-Aufwand verschiedener Optionen im Auge behalten wird.

Sie können sich jederzeit an uns wenden, wenn Sie Fragen zur KI-Compliance haben oder das Thema näher erörtern möchten.

LLM Benchmarks Archiv

Mehr erfahrenTransformieren Sie Ihre digitalen Projekte mit den besten KI-Sprachmodellen!

Entdecken Sie die transformative Kraft der besten LLM und revolutionieren Sie Ihre digitalen Produkte mit KI! Bleiben Sie zukunftsorientiert, steigern Sie die Effizienz und sichern Sie sich einen klaren Wettbewerbsvorteil. Wir unterstützen Sie dabei, Ihren Business Value auf das nächste Level zu heben.

Martin WarnungSales Consultant

Erfahren Sie mehr

ChatGPT & Co: Oktober-Benchmarks für Sprachmodelle

ChatGPT & Co: September-Benchmarks für Sprachmodelle

ChatGPT & Co: November-Benchmarks für Sprachmodelle

ChatGPT & Co: Dezember-Benchmarks für Sprachmodelle

ChatGPT & Co: Jänner-Benchmarks für Sprachmodelle

In 8 Schritten zu AI-Innovationen im Unternehmen

Fehler in der Entwicklung von AI-Assistenten

8 Tipps zur Entwicklung von AI-Assistenten

Die Zukunft der KI: Enterprise RAG Challenge

Microsoft Azure-Ressourcen automatisch skalieren

Artificial Intelligence (AI) mit Spurhalteassistent im Griff

Eventreihe: KI Governance

Standardisiertes Datenmanagement schafft Basis für Reporting

IBM Cloud Pak for Data Accelerator

Amazon EC2: Performance richtig messen und optimieren!

AWS Cloud: So optimieren Sie Ihre Kosten mit IBM Turbonomic!

Azure Cloud: Kosten mit IBM Turbonomic optimieren!

Elastic Block Storage: Performance und Kosten optimieren

Lizenzmanagement fest im Griff - Das sollten Sie wissen!

In 6 Schritten zur passenden Data Analytics-Lösung

TIMETOACT unterstützt KC Risk bei Benchmarking & Reporting

Standardisiertes Datenmanagement bei TRUMPF

IAV erreicht ISO/IEC 5230 Zertifizierung

KI Governance

Interaktives Onlineportal identifiziert passende Mitarbeiter

Managed Service Support für optimales Lizenzmanagement

IBM Cloud Pak for Data – Test-Drive

IBM Watson Knowledge Studio

IBM Watson Discovery