Der November brachte viele Veränderungen in den TOP-10 unseres LLM-Benchmarks mit sich. Außerdem gab es einige Neuerungen in der Art und Weise, wie wir LLM-gestützte Produkte entwickeln.

- Update: Claude Sonnet 3.5 v2 – Kleine Verbesserungen der Fähigkeiten und hervorragende PDF-Verarbeitung.

- GPT-4o ab 20. November – Direkt in den TOP 3!

- Qwen 2.5 Coder 32B Instruct – Mittelmäßig, aber treibt den Stand der Technik voran!

- Qwen QwQ 32B Preview – Fast zu schlau für sein eigenes Wohl.

- Gemini Experimental 1121 – Solide, aber schwer zugänglich.

- Pläne für LLM-Benchmarks v2 – Fokus auf konkrete Anwendungsfälle und Fähigkeiten.

- Text-to-SQL-Benchmark

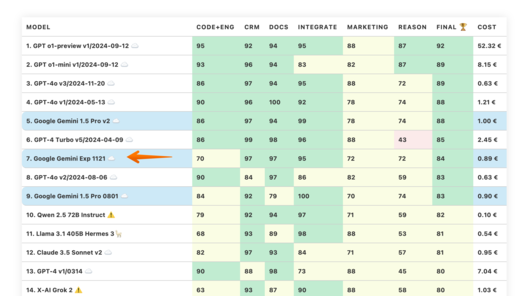

LLM Benchmarks | November 2024

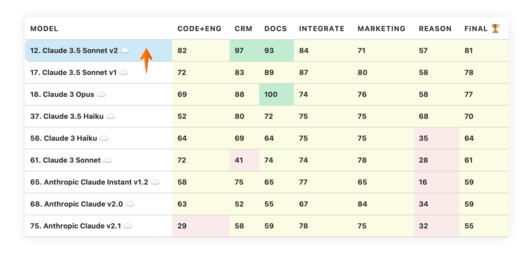

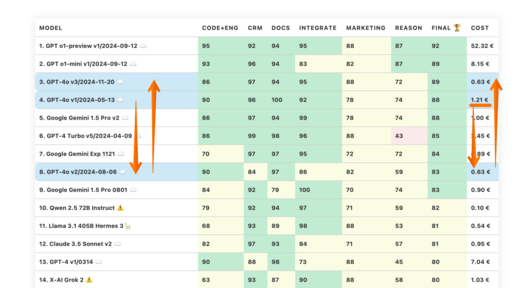

Die Benchmarks bewerten die Modelle in Bezug auf ihre Eignung für die digitale Produktentwicklung. Je höher die Punktezahl, desto besser.

☁️ - Cloud-Modelle mit proprietärer Lizenz

✅ - Open-Source-Modelle, die lokal ohne Einschränkungen ausgeführt werden können

🦙 - Lokale Modelle mit Llama2-Lizenz

Kann das Modell Code generieren und bei der Programmierung helfen?

Die geschätzten Kosten für die Ausführung der Arbeitslast. Für cloud-basierte Modelle berechnen wir die Kosten gemäß der Preisgestaltung. Für lokale Modelle schätzen wir die Kosten auf Grundlage der GPU-Anforderungen für jedes Modell, der GPU-Mietkosten, der Modellgeschwindigkeit und des operationellen Overheads.

Wie gut unterstützt das Modell die Arbeit mit Produktkatalogen und Marktplätzen?

Wie gut kann das Modell mit großen Dokumenten und Wissensdatenbanken arbeiten?

Kann das Modell problemlos mit externen APIs, Diensten und Plugins interagieren?

Wie gut kann das Modell bei Marketingaktivitäten unterstützen, z.B. beim Brainstorming, der Ideenfindung und der Textgenerierung?

Wie gut kann das Modell in einem gegebenen Kontext logisch denken und Schlussfolgerungen ziehen?

Die Spalte "Speed" gibt die geschätzte Geschwindigkeit des Modells in Anfragen pro Sekunde an (ohne Batching). Je höher die Geschwindigkeit, desto besser.

| Modell | Code | Crm | Docs | Integrate | Marketing | Reason | Ergebnis | Kosten | Speed |

|---|---|---|---|---|---|---|---|---|---|

| 1. GPT o1-preview v1/2024-09-12 ☁️ | 95 | 92 | 94 | 95 | 88 | 87 | 92 | 52.32 € | 0.08 rps |

| 2. GPT o1-mini v1/2024-09-12 ☁️ | 93 | 96 | 94 | 83 | 82 | 87 | 89 | 8.15 € | 0.16 rps |

| 3. GPT-4o v3/2024-11-20 ☁️ | 86 | 97 | 94 | 95 | 88 | 72 | 89 | 0.63 € | 1.14 rps |

| 4. GPT-4o v1/2024-05-13 ☁️ | 90 | 96 | 100 | 92 | 78 | 74 | 88 | 1.21 € | 1.44 rps |

| 5. Google Gemini 1.5 Pro v2 ☁️ | 86 | 97 | 94 | 99 | 78 | 74 | 88 | 1.00 € | 1.18 rps |

| 6. GPT-4 Turbo v5/2024-04-09 ☁️ | 86 | 99 | 98 | 96 | 88 | 43 | 85 | 2.45 € | 0.84 rps |

| 7. Google Gemini Exp 1121 ☁️ | 70 | 97 | 97 | 95 | 72 | 72 | 84 | 0.89 € | 0.49 rps |

| 8. GPT-4o v2/2024-08-06 ☁️ | 90 | 84 | 97 | 86 | 82 | 59 | 83 | 0.63 € | 1.49 rps |

| 9. Google Gemini 1.5 Pro 0801 ☁️ | 84 | 92 | 79 | 100 | 70 | 74 | 83 | 0.90 € | 0.83 rps |

| 10. Qwen 2.5 72B Instruct ⚠️ | 79 | 92 | 94 | 97 | 71 | 59 | 82 | 0.10 € | 0.66 rps |

| 11. Llama 3.1 405B Hermes 3🦙 | 68 | 93 | 89 | 98 | 88 | 53 | 81 | 0.54 € | 0.49 rps |

| 12. Claude 3.5 Sonnet v2 ☁️ | 82 | 97 | 93 | 84 | 71 | 57 | 81 | 0.95 € | 0.09 rps |

| 13. GPT-4 v1/0314 ☁️ | 90 | 88 | 98 | 73 | 88 | 45 | 80 | 7.04 € | 1.31 rps |

| 14. X-AI Grok 2 ⚠️ | 63 | 93 | 87 | 90 | 88 | 58 | 80 | 1.03 € | 0.31 rps |

| 15. GPT-4 v2/0613 ☁️ | 90 | 83 | 95 | 73 | 88 | 45 | 79 | 7.04 € | 2.16 rps |

| 16. GPT-4o Mini ☁️ | 63 | 87 | 80 | 73 | 100 | 65 | 78 | 0.04 € | 1.46 rps |

| 17. Claude 3.5 Sonnet v1 ☁️ | 72 | 83 | 89 | 87 | 80 | 58 | 78 | 0.94 € | 0.09 rps |

| 18. Claude 3 Opus ☁️ | 69 | 88 | 100 | 74 | 76 | 58 | 77 | 4.69 € | 0.41 rps |

| 19. Meta Llama3.1 405B Instruct🦙 | 81 | 93 | 92 | 75 | 75 | 48 | 77 | 2.39 € | 1.16 rps |

| 20. GPT-4 Turbo v4/0125-preview ☁️ | 66 | 97 | 100 | 83 | 75 | 43 | 77 | 2.45 € | 0.84 rps |

| 21. Google LearnLM 1.5 Pro Experimental ⚠️ | 48 | 97 | 85 | 96 | 64 | 72 | 77 | 0.31 € | 0.83 rps |

| 22. GPT-4 Turbo v3/1106-preview ☁️ | 66 | 75 | 98 | 73 | 88 | 60 | 76 | 2.46 € | 0.68 rps |

| 23. Qwen 2.5 32B Coder Instruct ⚠️ | 43 | 94 | 98 | 98 | 76 | 46 | 76 | 0.05 € | 0.82 rps |

| 24. DeepSeek v2.5 236B ⚠️ | 57 | 80 | 91 | 80 | 88 | 57 | 75 | 0.03 € | 0.42 rps |

| 25. Meta Llama 3.1 70B Instruct f16🦙 | 74 | 89 | 90 | 75 | 75 | 48 | 75 | 1.79 € | 0.90 rps |

| 26. Google Gemini 1.5 Flash v2 ☁️ | 64 | 96 | 89 | 76 | 81 | 44 | 75 | 0.06 € | 2.01 rps |

| 27. Google Gemini 1.5 Pro 0409 ☁️ | 68 | 97 | 96 | 80 | 75 | 26 | 74 | 0.95 € | 0.59 rps |

| 28. Meta Llama 3 70B Instruct🦙 | 81 | 83 | 84 | 67 | 81 | 45 | 73 | 0.06 € | 0.85 rps |

| 29. GPT-3.5 v2/0613 ☁️ | 68 | 81 | 73 | 87 | 81 | 50 | 73 | 0.34 € | 1.46 rps |

| 30. Mistral Large 123B v2/2407 ☁️ | 68 | 79 | 68 | 75 | 75 | 70 | 72 | 0.57 € | 1.02 rps |

| 31. Google Gemini Flash 1.5 8B ☁️ | 70 | 93 | 78 | 67 | 76 | 48 | 72 | 0.01 € | 1.19 rps |

| 32. Google Gemini 1.5 Pro 0514 ☁️ | 73 | 96 | 79 | 100 | 25 | 60 | 72 | 1.07 € | 0.92 rps |

| 33. Google Gemini 1.5 Flash 0514 ☁️ | 32 | 97 | 100 | 76 | 72 | 52 | 72 | 0.06 € | 1.77 rps |

| 34. Google Gemini 1.0 Pro ☁️ | 66 | 86 | 83 | 79 | 88 | 28 | 71 | 0.37 € | 1.36 rps |

| 35. Meta Llama 3.2 90B Vision🦙 | 74 | 84 | 87 | 77 | 71 | 32 | 71 | 0.23 € | 1.10 rps |

| 36. GPT-3.5 v3/1106 ☁️ | 68 | 70 | 71 | 81 | 78 | 58 | 71 | 0.24 € | 2.33 rps |

| 37. Claude 3.5 Haiku ☁️ | 52 | 80 | 72 | 75 | 75 | 68 | 70 | 0.32 € | 1.24 rps |

| 38. GPT-3.5 v4/0125 ☁️ | 63 | 87 | 71 | 77 | 78 | 43 | 70 | 0.12 € | 1.43 rps |

| 39. Cohere Command R+ ☁️ | 63 | 80 | 76 | 72 | 70 | 58 | 70 | 0.83 € | 1.90 rps |

| 40. Mistral Large 123B v3/2411 ☁️ | 68 | 75 | 64 | 76 | 82 | 51 | 70 | 0.56 € | 0.66 rps |

| 41. Qwen1.5 32B Chat f16 ⚠️ | 70 | 90 | 82 | 76 | 78 | 20 | 69 | 0.97 € | 1.66 rps |

| 42. Gemma 2 27B IT ⚠️ | 61 | 72 | 87 | 74 | 89 | 32 | 69 | 0.07 € | 0.90 rps |

| 43. Mistral 7B OpenChat-3.5 v3 0106 f16 ✅ | 68 | 87 | 67 | 74 | 88 | 25 | 68 | 0.32 € | 3.39 rps |

| 44. Meta Llama 3 8B Instruct f16🦙 | 79 | 62 | 68 | 70 | 80 | 41 | 67 | 0.32 € | 3.33 rps |

| 45. Gemma 7B OpenChat-3.5 v3 0106 f16 ✅ | 63 | 67 | 84 | 58 | 81 | 46 | 67 | 0.21 € | 5.09 rps |

| 46. GPT-3.5-instruct 0914 ☁️ | 47 | 92 | 69 | 69 | 88 | 33 | 66 | 0.35 € | 2.15 rps |

| 47. GPT-3.5 v1/0301 ☁️ | 55 | 82 | 69 | 81 | 82 | 26 | 66 | 0.35 € | 4.12 rps |

| 48. Llama 3 8B OpenChat-3.6 20240522 f16 ✅ | 76 | 51 | 76 | 65 | 88 | 38 | 66 | 0.28 € | 3.79 rps |

| 49. Mistral 7B OpenChat-3.5 v1 f16 ✅ | 58 | 72 | 72 | 71 | 88 | 33 | 66 | 0.49 € | 2.20 rps |

| 50. Mistral 7B OpenChat-3.5 v2 1210 f16 ✅ | 63 | 73 | 72 | 66 | 88 | 30 | 65 | 0.32 € | 3.40 rps |

| 51. Qwen 2.5 7B Instruct ⚠️ | 48 | 77 | 80 | 68 | 69 | 47 | 65 | 0.07 € | 1.25 rps |

| 52. Starling 7B-alpha f16 ⚠️ | 58 | 66 | 67 | 73 | 88 | 34 | 64 | 0.58 € | 1.85 rps |

| 53. Mistral Nemo 12B v1/2407 ☁️ | 54 | 58 | 51 | 99 | 75 | 49 | 64 | 0.03 € | 1.22 rps |

| 54. Meta Llama 3.2 11B Vision🦙 | 70 | 71 | 65 | 70 | 71 | 36 | 64 | 0.04 € | 1.49 rps |

| 55. Llama 3 8B Hermes 2 Theta🦙 | 61 | 73 | 74 | 74 | 85 | 16 | 64 | 0.05 € | 0.55 rps |

| 56. Claude 3 Haiku ☁️ | 64 | 69 | 64 | 75 | 75 | 35 | 64 | 0.08 € | 0.52 rps |

| 57. Yi 1.5 34B Chat f16 ⚠️ | 47 | 78 | 70 | 74 | 86 | 26 | 64 | 1.18 € | 1.37 rps |

| 58. Liquid: LFM 40B MoE ⚠️ | 72 | 69 | 65 | 63 | 82 | 24 | 63 | 0.00 € | 1.45 rps |

| 59. Meta Llama 3.1 8B Instruct f16🦙 | 57 | 74 | 62 | 74 | 74 | 32 | 62 | 0.45 € | 2.41 rps |

| 60. Qwen2 7B Instruct f32 ⚠️ | 50 | 81 | 81 | 61 | 66 | 31 | 62 | 0.46 € | 2.36 rps |

| 61. Claude 3 Sonnet ☁️ | 72 | 41 | 74 | 74 | 78 | 28 | 61 | 0.95 € | 0.85 rps |

| 62. Mistral Small v3/2409 ☁️ | 43 | 75 | 71 | 74 | 75 | 26 | 61 | 0.06 € | 0.81 rps |

| 63. Mistral Pixtral 12B ✅ | 53 | 69 | 73 | 63 | 64 | 40 | 60 | 0.03 € | 0.83 rps |

| 64. Mixtral 8x22B API (Instruct) ☁️ | 53 | 62 | 62 | 97 | 75 | 7 | 59 | 0.17 € | 3.12 rps |

| 65. Anthropic Claude Instant v1.2 ☁️ | 58 | 75 | 65 | 77 | 65 | 16 | 59 | 2.10 € | 1.49 rps |

| 66. Codestral Mamba 7B v1 ✅ | 53 | 66 | 51 | 97 | 71 | 17 | 59 | 0.30 € | 2.82 rps |

| 67. Inflection 3 Productivity ⚠️ | 46 | 59 | 39 | 70 | 79 | 61 | 59 | 0.92 € | 0.17 rps |

| 68. Anthropic Claude v2.0 ☁️ | 63 | 52 | 55 | 67 | 84 | 34 | 59 | 2.19 € | 0.40 rps |

| 69. Cohere Command R ☁️ | 45 | 66 | 57 | 74 | 84 | 27 | 59 | 0.13 € | 2.50 rps |

| 70. Qwen1.5 7B Chat f16 ⚠️ | 56 | 81 | 60 | 56 | 60 | 36 | 58 | 0.29 € | 3.76 rps |

| 71. Mistral Large v1/2402 ☁️ | 37 | 49 | 70 | 83 | 84 | 25 | 58 | 0.58 € | 2.11 rps |

| 72. Microsoft WizardLM 2 8x22B ⚠️ | 48 | 76 | 79 | 59 | 62 | 22 | 58 | 0.13 € | 0.70 rps |

| 73. Qwen1.5 14B Chat f16 ⚠️ | 50 | 58 | 51 | 72 | 84 | 22 | 56 | 0.36 € | 3.03 rps |

| 74. MistralAI Ministral 8B ✅ | 56 | 55 | 41 | 82 | 68 | 30 | 55 | 0.02 € | 1.02 rps |

| 75. Anthropic Claude v2.1 ☁️ | 29 | 58 | 59 | 78 | 75 | 32 | 55 | 2.25 € | 0.35 rps |

| 76. Mistral 7B OpenOrca f16 ☁️ | 54 | 57 | 76 | 36 | 78 | 27 | 55 | 0.41 € | 2.65 rps |

| 77. MistralAI Ministral 3B ✅ | 50 | 48 | 39 | 89 | 60 | 41 | 54 | 0.01 € | 1.02 rps |

| 78. Llama2 13B Vicuna-1.5 f16🦙 | 50 | 37 | 55 | 62 | 82 | 37 | 54 | 0.99 € | 1.09 rps |

| 79. Mistral 7B Instruct v0.1 f16 ☁️ | 34 | 71 | 69 | 63 | 62 | 23 | 54 | 0.75 € | 1.43 rps |

| 80. Meta Llama 3.2 3B🦙 | 52 | 71 | 66 | 71 | 44 | 14 | 53 | 0.01 € | 1.25 rps |

| 81. Google Recurrent Gemma 9B IT f16 ⚠️ | 58 | 27 | 71 | 64 | 56 | 23 | 50 | 0.89 € | 1.21 rps |

| 82. Codestral 22B v1 ✅ | 38 | 47 | 44 | 84 | 66 | 13 | 49 | 0.06 € | 4.03 rps |

| 83. Qwen: QwQ 32B Preview ⚠️ | 43 | 32 | 74 | 52 | 48 | 40 | 48 | 0.05 € | 0.63 rps |

| 84. Llama2 13B Hermes f16🦙 | 50 | 24 | 37 | 75 | 60 | 42 | 48 | 1.00 € | 1.07 rps |

| 85. IBM Granite 34B Code Instruct f16 ☁️ | 63 | 49 | 34 | 67 | 57 | 7 | 46 | 1.07 € | 1.51 rps |

| 86. Meta Llama 3.2 1B🦙 | 32 | 40 | 33 | 53 | 68 | 51 | 46 | 0.02 € | 1.69 rps |

| 87. Mistral Small v2/2402 ☁️ | 33 | 42 | 45 | 88 | 56 | 8 | 46 | 0.06 € | 3.21 rps |

| 88. Mistral Small v1/2312 (Mixtral) ☁️ | 10 | 67 | 63 | 65 | 56 | 8 | 45 | 0.06 € | 2.21 rps |

| 89. DBRX 132B Instruct ⚠️ | 43 | 39 | 43 | 74 | 59 | 10 | 45 | 0.26 € | 1.31 rps |

| 90. NVIDIA Llama 3.1 Nemotron 70B Instruct🦙 | 68 | 54 | 25 | 72 | 28 | 21 | 45 | 0.09 € | 0.53 rps |

| 91. Mistral Medium v1/2312 ☁️ | 41 | 43 | 44 | 59 | 62 | 12 | 44 | 0.81 € | 0.35 rps |

| 92. Microsoft WizardLM 2 7B ⚠️ | 53 | 34 | 42 | 66 | 53 | 13 | 43 | 0.02 € | 0.89 rps |

| 93. Llama2 13B Puffin f16🦙 | 37 | 15 | 44 | 67 | 56 | 39 | 43 | 4.70 € | 0.23 rps |

| 94. Mistral Tiny v1/2312 (7B Instruct v0.2) ☁️ | 22 | 47 | 59 | 53 | 62 | 8 | 42 | 0.05 € | 2.39 rps |

| 95. Gemma 2 9B IT ⚠️ | 45 | 25 | 47 | 36 | 68 | 13 | 39 | 0.02 € | 0.88 rps |

| 96. Meta Llama2 13B chat f16🦙 | 22 | 38 | 17 | 65 | 75 | 6 | 37 | 0.75 € | 1.44 rps |

| 97. Mistral 7B Zephyr-β f16 ✅ | 37 | 34 | 46 | 62 | 29 | 4 | 35 | 0.46 € | 2.34 rps |

| 98. Meta Llama2 7B chat f16🦙 | 22 | 33 | 20 | 62 | 50 | 18 | 34 | 0.56 € | 1.93 rps |

| 99. Mistral 7B Notus-v1 f16 ⚠️ | 10 | 54 | 25 | 60 | 48 | 4 | 33 | 0.75 € | 1.43 rps |

| 100. Orca 2 13B f16 ⚠️ | 18 | 22 | 32 | 29 | 67 | 20 | 31 | 0.95 € | 1.14 rps |

| 101. Mistral 7B Instruct v0.2 f16 ☁️ | 11 | 30 | 54 | 25 | 58 | 8 | 31 | 0.96 € | 1.12 rps |

| 102. Mistral 7B v0.1 f16 ☁️ | 0 | 9 | 48 | 63 | 52 | 12 | 31 | 0.87 € | 1.23 rps |

| 103. Google Gemma 2B IT f16 ⚠️ | 33 | 28 | 16 | 47 | 15 | 20 | 27 | 0.30 € | 3.54 rps |

| 104. Microsoft Phi 3 Medium 4K Instruct 14B f16 ⚠️ | 5 | 34 | 30 | 32 | 47 | 8 | 26 | 0.82 € | 1.32 rps |

| 105. Orca 2 7B f16 ⚠️ | 22 | 0 | 26 | 26 | 52 | 4 | 22 | 0.78 € | 1.38 rps |

| 106. Google Gemma 7B IT f16 ⚠️ | 0 | 0 | 0 | 6 | 62 | 0 | 11 | 0.99 € | 1.08 rps |

| 107. Meta Llama2 7B f16🦙 | 0 | 5 | 22 | 3 | 28 | 2 | 10 | 0.95 € | 1.13 rps |

| 108. Yi 1.5 9B Chat f16 ⚠️ | 0 | 4 | 29 | 17 | 0 | 8 | 10 | 1.41 € | 0.76 rps |

Claude 3.5 v2 Update

Im Oktober LLM-Benchmark haben wir berichtet, dass Anthropic eine kleine Verbesserung der Fähigkeiten von Claude 3.5 v2 erreicht hat. Diese Verbesserung ist zwar vorhanden, aber nicht ausreichend, um das Modell in die TOP-10 zu bringen.

Warum Anthropic Claude 3.5 Sonnet v2 die erste Wahl für Datenextraktionsprojekte ist

Trotz seiner Platzierung außerhalb der TOP-10 ist Anthropic Claude 3.5 Sonnet v2 aktuell unsere bevorzugte Wahl für Datenextraktionsprojekte, beispielsweise im Rahmen von Geschäftsautomatisierung in der Fertigungsindustrie. Warum?

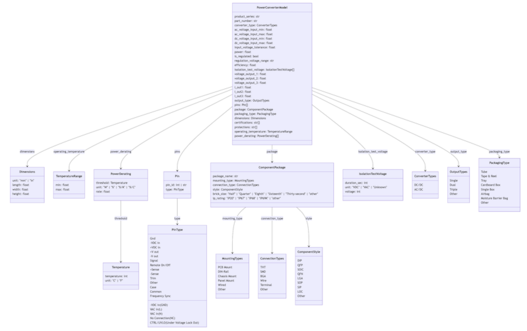

Stellen Sie sich vor, Sie müssen präzise Produktspezifikationen für 20.000 elektrische Komponenten aus 1.000 Datenblättern extrahieren. Diese PDFs enthalten oft komplexe Tabellen oder sogar Diagramme. Die extrahierten Daten könnten dann für Produktvergleiche, die Bereitstellung von äquivalenten Komponenten in Inline-Anzeigen oder Entscheidungen in der Lieferkette genutzt werden.

Anthropic Claude 3.5 Sonnet v2 überzeugt durch zwei gut kombinierte Features:

Native PDF-Verarbeitung

Die API von Anthropic ermöglicht es, PDF-Dateien direkt zusammen mit den Extraktionsanweisungen hochzuladen. Im Hintergrund zerlegt die API das PDF in Seiten und lädt jede Seite doppelt hoch – als Bild und als Text. Diese Lösung funktioniert so zuverlässig, dass sie aufwändige Setups mit lokalen Visual Language Models (VLMs) ersetzt.

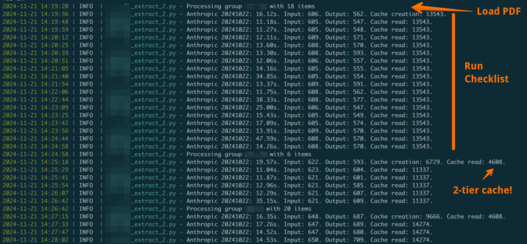

Prompt-Caching

PDFs benötigen viele Tokens, besonders wenn ein umfangreicher System-Prompt hinzugefügt wird. Um die Verarbeitung zu beschleunigen, die Genauigkeit zu erhöhen und Kosten zu senken, setzen wir auf das zweistufige Prompt-Caching von Anthropic. Dadurch müssen die Kosten für die Tokenisierung eines PDFs nur einmal bezahlt werden.

Beispiel für einen Extraktions-Prompt

System-Prompt:

"Ihre Aufgabe ist es, Produktdaten aus dem PDF zu extrahieren. Hier ist das Schema (großes Schema) und der Unternehmenskontext."Dokumenten-Prompt:

"Hier ist das PDF zur Datenextraktion. Es enthält mehrere Produkte."Task:

"Extrahieren Sie Produkt X aus dem PDF."

Dieser Ansatz ermöglicht die Extraktion mehrerer Produkte aus einem einzigen PDF, indem ein Checklisten-Muster verwendet wird. Der System-Prompt (1) und der Dokumenten-Prompt (2) werden für alle Extraktionsanfragen zu demselben PDF zwischengespeichert. Der System-Prompt (1) wird sogar für alle Anfragen dieses PDF-Typs allgemein gecached.

Vorteile des Prompt-Cachings

Wann immer ein Teil des Prompts auf dem Server zwischengespeichert wird, senkt das die Kosten und beschleunigt die Verarbeitung. Zum Beispiel um 30–70 % schneller und 50–90 % günstiger, wie in der Dokumentation von Anthropic beschrieben. Bei Datenextraktionsfällen liegen die Kosteneinsparungen typischerweise eher am oberen Ende dieses Bereichs.

So sieht es in der Praxis aus

- 'Cache creation' zeigt, wann ein Teil des Prompts gespeichert wird.

- 'Cache read' zeigt, wann ein gespeicherter Prompt wiederverwendet wird – was Zeit und Geld spart.

Dank dieser optimierten Funktionen ist Claude 3.5 Sonnet v2 ein leistungsstarkes Tool für datenintensive Extraktionsprojekte in der Fertigungsindustrie.

Es gibt einen kleinen Haken: Die Modelle von Anthropic verfügen nicht über die Structured Output-Fähigkeit von OpenAI. Man könnte daher denken, dass zwei wichtige Funktionen verloren gehen:

- Exakte Einhaltung eines Schemas

- Die Möglichkeit, einen benutzerdefinierten Chain-of-Thought-Prozess festzulegen, der das LLM durch den Datenextraktionsprozess führt

Doch das ist nicht der Fall! Structured Output ist lediglich eine Inferenzfunktion, die eine eingeschränkte Decodierung (Token-Auswahl) ermöglicht, um ein Schema exakt zu befolgen. Ein leistungsfähiges LLM kann auch ohne diese Funktion komplexe Strukturen extrahieren. Dabei folgt es dem in der Schema-Definition kodierten Chain-of-Thought-Prozess.

Anthropic Claude 3.5 Sonnet v2 ist durchaus in der Lage, dies zu leisten. In 5–7 % der Fälle, in denen das Ergebnis ein leicht ungültiges Schema liefert, können wir die Ergebnisse an GPT-4o übergeben, um das Schema zu korrigieren.

Zum Vergleich: Hier ist ein Beispiel für eine Structured Output-Definition aus einem unserer Projekte (die Bildqualität wurde absichtlich reduziert).

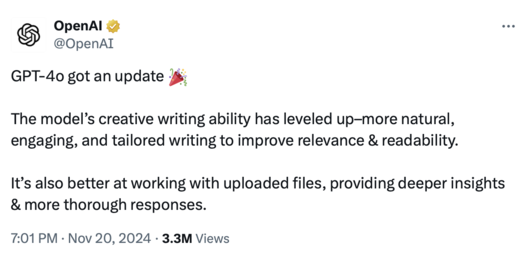

GPT-4o seit dem 20. November – TOP 3

OpenAI hat sich nicht die Mühe gemacht, eine offizielle Ankündigung für dieses Modell (gpt-4o-2024-11-20 in der API) zu veröffentlichen. Stattdessen haben sie das Update einfach nur getwittert:

Das Modell verdient eine besondere Erwähnung in unseren Benchmarks. Im Vergleich zur vorherigen Version GPT-4o v2/2024-08-06 zeigt das Modell spürbare Verbesserungen, insbesondere in der Kategorie Reasoning.

Man kann auch das übliche Muster von OpenAI bei den Modellen beobachten:

- Zuerst veröffentlichen sie ein neues, leistungsstarkes Modell (in diesem Fall GPT-4o v1).

- Dann bringen sie das nächste Modell derselben Familie heraus, das wesentlich kostengünstiger ist.

- Schließlich verbessern sie das Modell weiter, sodass es leistungsfähiger wird, aber weiterhin zu niedrigeren Kosten betrieben werden kann.

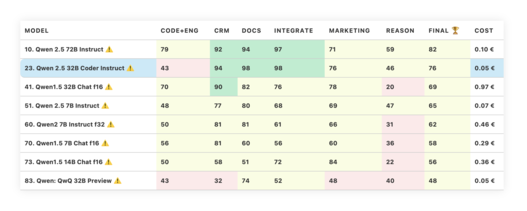

Mehrere Qwen-Modelle von Alibaba

Qwen 2.5 Coder 32B Instruct ist ein neues Modell aus der Qwen-Familie. Es wird Sie zunächst enttäuschen, aber anschließend positiv überraschen.

Das Modell selbst kann über HuggingFace heruntergeladen und lokal auf Ihrer Hardware ausgeführt werden.

Der enttäuschende Teil: Dieses Coding-Modell hat in unserer Kategorie Code+Eng schlecht abgeschnitten. Es war zwar in der Lage, grundlegende Coding-Aufgaben zu bewältigen, scheiterte jedoch an komplexeren Herausforderungen wie Code-Review und Analyse. Zudem ist das allgemeine Reasoning-Niveau recht niedrig – nur 46.

Was würden Sie von einem Modell erwarten, das „Coder“ heißt? Tatsächlich ist dieses Modell im Bereich Coding ziemlich gut. Es hat im Coding-Benchmark für komplexe Text-to-SQL-Aufgaben genauso gut abgeschnitten wie Sonnet 3.5 (mehr dazu später).

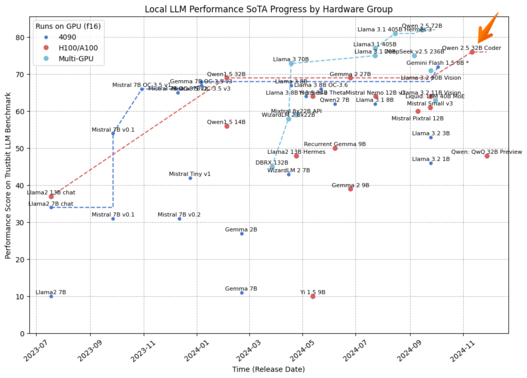

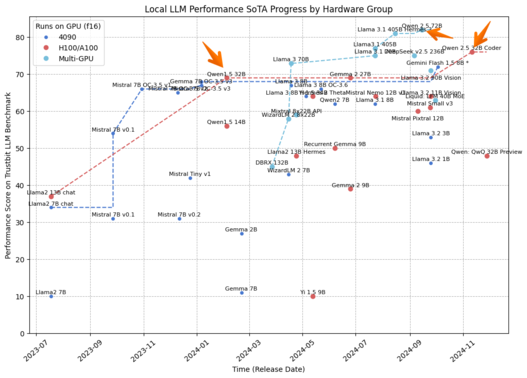

Was macht dieses Modell also so besonders? Dieses coding-orientierte Modell stellt eine neue Qualitätsverbesserung für lokale Modelle dar, insbesondere in der Kategorie: „Es läuft auf A100/H100 GPUs!“

Übrigens ist es interessant zu bemerken, dass einige andere bedeutende Qualitätsverbesserungen, die den Stand der Technik für lokale Modelle vorangetrieben haben, ebenfalls von Qwen initiiert wurden.

Es ist auch interessant, dass der „o1-Killer“ von Qwen in unserem Benchmark nicht so gut abgeschnitten hat. Qwen: QwQ 32B Preview wurde entwickelt, um den Stand der Technik in den Reasoning-Fähigkeiten voranzutreiben. Laut einigen Benchmarks ist dies gelungen. Allerdings scheint es nicht für produktive Aufgaben und Geschäftsautomatisierung geeignet zu sein. Warum? Es redet zu viel und hält sich nicht an die Anweisungen.

Ein Beispiel:

Bei folgendem Prompt, der durch einige Beispiele verstärkt wurde:

„Extrahiere Produkteigenschaften aus dem bereitgestellten Text. Antworte im Format: ‚Zahl Einheit‘ oder ‚N/A‘, wenn dies nicht bestimmbar ist. Entferne Anführungszeichen, Tausendertrennzeichen und Kommentare.“

tendiert das Modell dazu, so zu beginnen:

„Okay, ich habe diesen Text über einen elektrischen Schraubendreher,...“

Selbst das kleine mistral-7b-instruct-f16 würde hingegen präzise etwas wie 1300 rpm antworten.

Das mag wie ein unfairer Vergleich zwischen QwQ und einem Top-Modell wie o1-preview erscheinen. o1 hat die Möglichkeit, vor seiner Antwort im Hintergrund zu „überlegen“ (es verwendet dafür Reasoning-Tokens).

Um die neuen Generationen von Reasoning-Modellen gerechter zu bewerten, werden wir in der nächsten großen Aktualisierung unseres Benchmarks einige Dinge ändern: Modelle dürfen vor ihrer Antwort „überlegen“. Modelle, die zu viel nachdenken, werden jedoch nativ durch ihre Kosten und die hohe Latenzzeit bestraft.

LLM Benchmark v2

Wir führen die aktuelle Version unseres Benchmarks nun seit fast anderthalb Jahren ohne größere Änderungen durch. Anpassungen wurden bewusst vermieden, um die Ergebnisse zwischen verschiedenen Modellen und Testläufen vergleichbar zu halten.

Seit Juli 2023 hat sich jedoch vieles in der Landschaft verändert:

- Structured Outputs – ermöglichen es, präzise Antwortformate zu definieren und sogar benutzerdefinierte Chain-of-Thought-Prozesse für komplexe Aufgaben zu steuern.

- Multimodale Sprachmodelle – können neben Texteingaben auch Bilder und Audio verarbeiten. Bildinputs werden beispielsweise intensiv bei der Dokumentenextraktion eingesetzt.

- Prompt Caching – verändert die Perspektive beim Aufbau von RAG-Systemen, beim Abarbeiten komplexer Checklisten oder bei der Datenextraktion aus zahlreichen Dokumenten.

- Neue Reasoning-Modelle – erlauben es, die Leistung von Modellen durch das Aufteilen komplexer Aufgaben in kleine Schritte voranzutreiben und dabei (kostenpflichtig) Zeit in ein durchdachtes Vorgehen zu investieren.

Zusätzlich haben wir tiefere Einblicke in den Aufbau von LLM-gestützten Systemen gewonnen und weitere Anwendungsfälle zu unserem KI-Portfolio hinzugefügt.

Es ist Zeit für einen umfassenden Neustart. Die Arbeit am TIMETOACT GROUP LLM Benchmark v2 hat bereits begonnen, und wir erwarten, den ersten Entwurf des Berichts Anfang nächsten Jahres zu veröffentlichen.

Der V2-Benchmark wird auf den Grundlagen von V1 aufbauen, sich aber stärker auf konkrete KI-Anwendungsfälle und neue Modellfähigkeiten konzentrieren. Auch können Sie sich auf mehr Diagramme freuen.

Gemini Experimental 1121 – Gut, aber schwer zugänglich

Gemini Experimental 1121 ist ein neues Prototyp-Modell von Google, das derzeit in Testumgebungen wie AI Studio oder OpenRouter verfügbar ist. Dieses Modell setzt zwar nicht den neuesten Stand der Technik für Gemini, bestätigt jedoch, dass Googles Präsenz in den TOP-10 kein Zufall ist. Es ist das dritte Gemini-Modell, das es in die TOP-10 geschafft hat.

Allerdings ist dieses Modell derzeit praktisch nicht nutzbar. Es wird zwar kostenlos angeboten, ist jedoch stark durch Rate Limits eingeschränkt. Es hat drei Tage und mehrere API-Schlüssel benötigt, um nur ein paar hundert Evaluierungen aus unserem Benchmark durchzuführen.

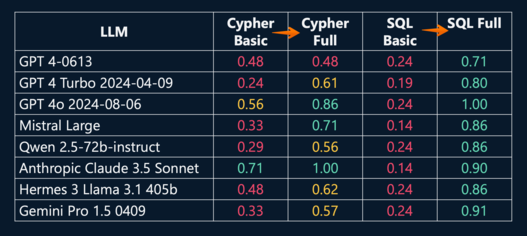

Text-to-SQL-Benchmark

Neo4j hat auf seiner NODES24-Konferenz ein Video veröffentlicht, in dem verschiedene LLMs hinsichtlich ihrer Leistung bei Text-to-SQL- und Text-to-Cypher-Aufgaben bewertet werden.

Ein Beispiel für eine Text-to-SQL-Aufgabe ist die Übersetzung einer menschlichen Anfrage in eine komplexe Abfrage gegen die SQL-Datenbank eines Unternehmens durch ein LLM. Dies wird häufig für Self-Service-Reporting eingesetzt. Text-to-Cypher funktioniert ähnlich, richtet sich jedoch an Graph-Datenbanken wie Neo4j.

Die Forschung und Präsentation wurde in Zusammenarbeit mit zwei Unternehmen der TIMETOACT GROUP durchgeführt: X-Integrate und TIMETOACT GROUP Österreich.

Die wichtigste Folie der Präsentation ist die unten gezeigte. Sie zeigt die Genauigkeit, mit der verschiedene LLMs Abfragen für eine komplexe Datenbank erstellt haben. Diese Datenbank enthielt Informationen über technische und organisatorische Abhängigkeiten im Unternehmen, die für das Risikomanagement genutzt wurden.

Die „Basic“-Scores zeigen die Ergebnisse ohne jegliche Performance-Optimierungen, während die „Full“-Scores eine Reihe von Optimierungen nutzen, um die Genauigkeit der Abfragegenerierung zu verbessern.

Mehr über diese Optimierungen (und den Benchmark) erfahren Sie in der Präsentation, die online auf YouTube verfügbar ist.

Einige dieser Text-to-Query-Aufgaben werden sogar in unseren kommenden LLM v2 Benchmark aufgenommen.

Transformieren Sie Ihre digitalen Projekte mit den besten KI-Sprachmodellen!

Entdecken Sie die transformative Kraft der besten LLM und revolutionieren Sie Ihre digitalen Produkte mit KI! Bleiben Sie zukunftsorientiert, steigern Sie die Effizienz und sichern Sie sich einen klaren Wettbewerbsvorteil. Wir unterstützen Sie dabei, Ihren Business Value auf das nächste Level zu heben.

Martin WarnungSales Consultant

Erfahren Sie mehr

ChatGPT & Co: Oktober-Benchmarks für Sprachmodelle

ChatGPT & Co: September-Benchmarks für Sprachmodelle

ChatGPT & Co: Dezember-Benchmarks für Sprachmodelle

ChatGPT & Co: Jänner-Benchmarks für Sprachmodelle

In 8 Schritten zu AI-Innovationen im Unternehmen

Fehler in der Entwicklung von AI-Assistenten

8 Tipps zur Entwicklung von AI-Assistenten

Die Zukunft der KI: Enterprise RAG Challenge

Microsoft Azure-Ressourcen automatisch skalieren

Artificial Intelligence (AI) mit Spurhalteassistent im Griff

KI Workshops für Unternehmen

Lizenzmanagement fest im Griff - Das sollten Sie wissen!

In 6 Schritten zur passenden Data Analytics-Lösung

AWS Cloud: So optimieren Sie Ihre Kosten mit IBM Turbonomic!

Amazon EC2: Performance richtig messen und optimieren!

Elastic Block Storage: Performance und Kosten optimieren

Azure Cloud: Kosten mit IBM Turbonomic optimieren!

Eventreihe: KI Governance

8 Tipps für ein erfolgreiches Automatisierungsprojekt

KI Governance

Standardisiertes Datenmanagement bei TRUMPF

IAV erreicht ISO/IEC 5230 Zertifizierung

Interaktives Onlineportal identifiziert passende Mitarbeiter

Managed Service Support für optimales Lizenzmanagement

TIMETOACT unterstützt KC Risk bei Benchmarking & Reporting

Künstliche Intelligenz im Treasury Management

ESG-Tagebuch | Wissenstransfer & Kommunikation | Teil 2

Automatisierter Rechnungseingang bei Kapsch

MAIN adaptiert automatisierte Rechnungseingangslösung

Mit IBM FileNet zum modernen Dokumentenarchiv

Automatisierte Planung von Transportwegen

Automatisierte Eingangrechnungsverarbeitung mit JobRouter®

Whitepaper: Eine Einführung ins API Management

Flexibilität bei der Datenauswertung eines Freizeitparks

Standardisiertes Datenmanagement schafft Basis für Reporting